探索CVPR 2024中视觉提示领域的5项突破性进展

探索CVPR 2024中视觉提示领域的5项突破性进展

ytkz计算机视觉领域视觉提示的五大进展

- 图像理解:简单的视觉标记能够帮助基础模型更好地理解图像中的特定部分。

- MLLMs(多模态大型语言模型):利用场景图使多模态大型语言模型能够更精准地描述图像,无需额外的训练数据。

- 基础模型改进:通过策略性的视觉提示改进视觉基础模型(如SAM),提升其性能。

- 增强泛化能力:训练人工智能快速识别新(未知)对象,同时保留对旧(已知)对象的记忆。

- 视觉提示与主动学习结合:AI能够智能地学习新的视觉任务,使用更少的例子,且不会忘记已学的知识。

本文探讨了视觉提示技术,这是一种使大型视觉模型能够适应新任务的方法。

除了定义这种方法并从系统角度阐述提示可调模型如何革新这一领域,我们还着重介绍了CVPR 2024上提出的五个最具影响力的视觉提示进展。

目录

- 什么是视觉提示Visual Prompting

- 视觉提示:一种系统视角

- CVPR 2024上抢尽风头的视觉提示进展

- 接下来会发生什么

1.什么是视觉提示?

What is Visual Prompting?

1.1 视觉提示的起源

视觉提示可以追溯到 2001 年发表的《Image Analogies》,其中研究人员开发了一种通过示例处理图像的策略,其中需要提示和查询才能检索响应。

在生成式人工智能时代,这类的提示方法有什么新变化?

1.提示是指调整模型去做他们没有经过专门训练的事情。用技术术语来说,提示可以使预先训练的模型适应看不见的分布。

2.提示在语言模型中得到了普及,其中大型预训练模型(即 GPT-4、文心一言、通义千问等)适应新任务。

3.视觉提示是指采用视觉大模型来执行(看不见的)视觉任务的过程。

1.2 理解视觉提示

为了理解视觉领域的提示,确定提示和微调(标准适应方法)之间的差异可能会很有用。

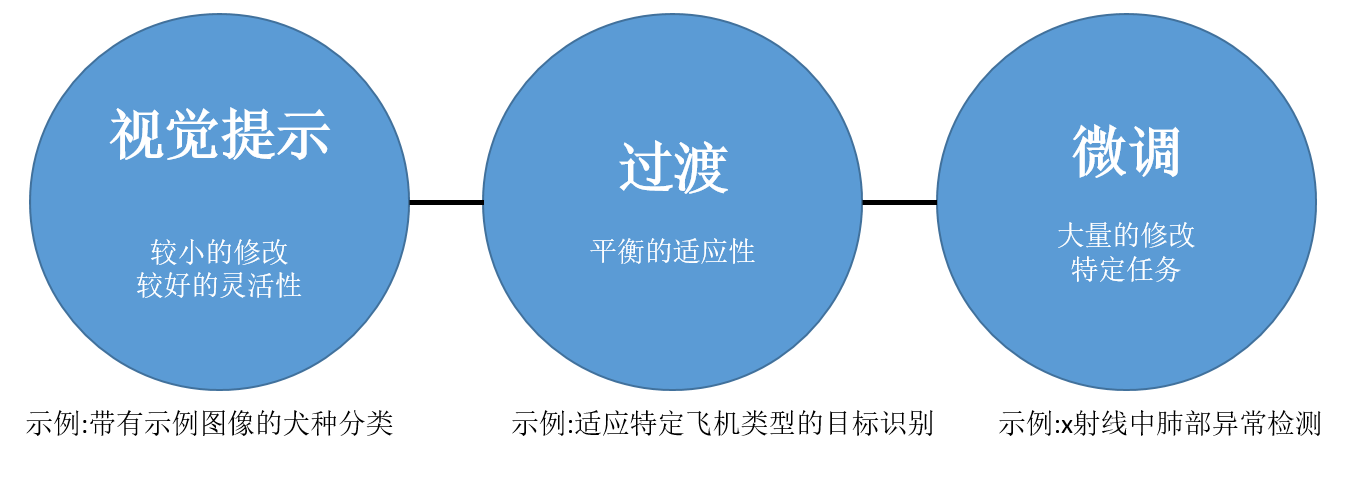

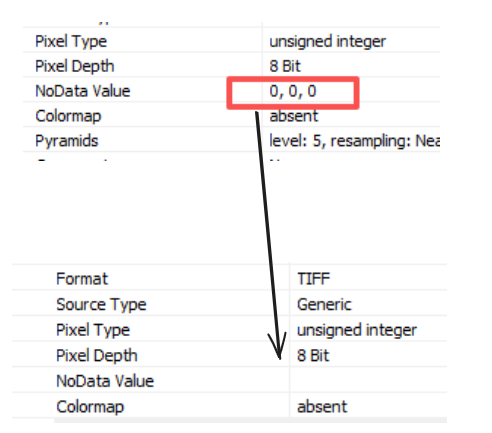

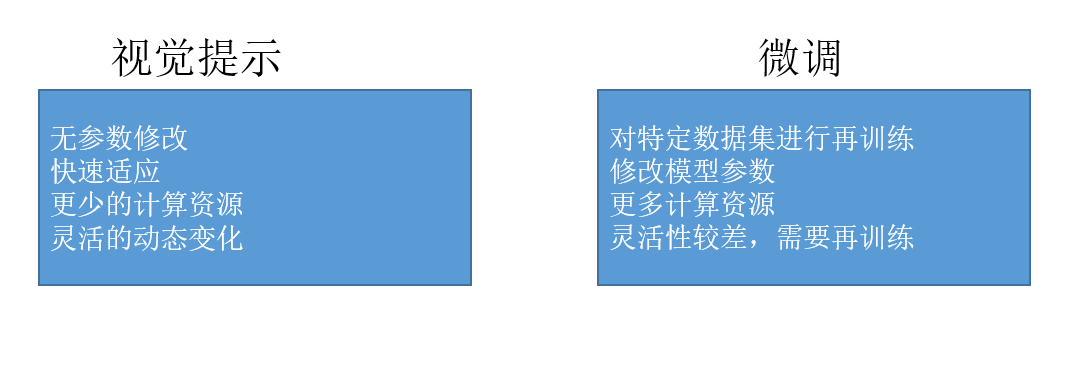

说明了计算机视觉基础模型背景下视觉提示和微调之间的主要区别。视觉提示采用特征来指导模型而不修改其参数。这种方法提供了灵活性,并且计算要求较低。另一方面,微调涉及在特定数据集上重新训练模型,修改其参数,以牺牲更高的计算资源为代价实现更好的特定于任务的性能。

然而,这两种方法并不是二元选择。它们都代表了基础模型的一系列潜在适应策略。如下图所示。

上图显示,当需要灵活性和速度时,视觉提示可能是针对某些应用程序(例如视觉搜索和检索或快速原型设计和实验)利用大规模视觉模型的最佳方法。

2.视觉提示:系统视角

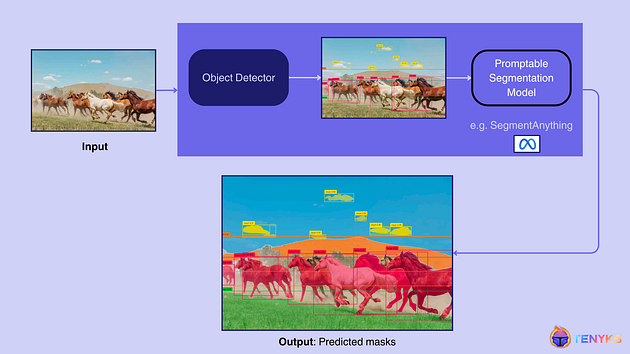

可提示的模型可以与其他系统无缝集成,使其能够在推理过程中作为更大的人工智能系统的一部分执行特定任务。

上图显示了一个采用即时基础模型作为较大系统组件的系统:

1.输入图像:系统从输入图像开始,在本例中显示了一群在田野里奔跑的马。

2.对象检测:输入图像由对象检测器(例如 YOLO-World [6])处理。此步骤识别并定位图像中的对象,在检测到的对象周围生成边界框。输出显示每匹马周围的边界框,以及天空中云的较小框。

3.分割:然后将检测到的框用作可提示分割模型的视觉提示(例如,Segment Anything)。该模型为每个检测到的对象生成精确的掩模,从而对图像进行更详细的分割。

3. 视觉提示的进步在 CVPR 2024 上大出风头

3.1 大型多模态模型的直观视觉提示

论文地址: cvpr open access

代码地址: : https://vip-llava.github.io/

创新点:引入了能够解码任意(自由形式)视觉提示的多模态模型,允许用户通过使用“红色边界框”或“指向箭头”等自然提示标记图像来直观地与模型交互,而无需复杂的操作区域编码。

潜在应用:

a) 医疗保健成像:允许医疗专业人员突出显示医学图像(例如 X 射线、MRI)中的特定区域,以进行更准确的诊断和分析。

b) 电子商务产品搜索:使用户能够标记产品图像的特定部分(例如突出显示鞋跟)以查找相似的商品或详细的产品信息。

3.2 零样本视觉提示增强AI对图像的理解

论文地址:https://arxiv.org/pdf/2311.17076

代码地址: https://github.com/chancharikmitra/CCoT

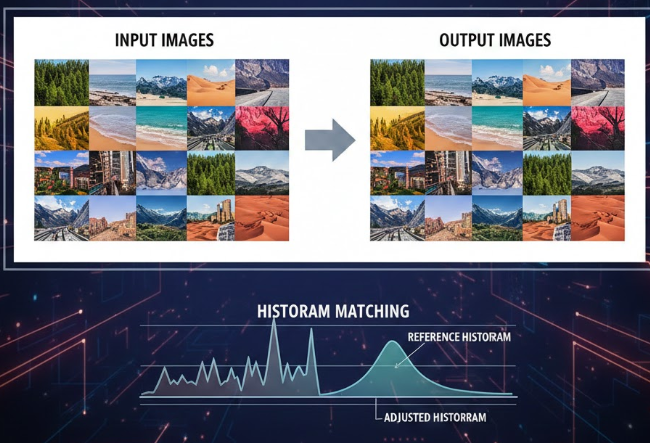

创新点:组合思想链(CCoT)方法的发展,其中涉及两步零样本提示过程。首先,多模态大语言模型 (MLLM) 根据任务提示从图像生成场景图。然后,该场景图用于提供上下文以生成详细且准确的响应,利用成分信息,而无需注释数据或微调。

潜在应用:

a) 视觉问答:通过全面理解视觉内容及其构成,对有关图像的问题提供精确的答案。

b) 监视:识别图像中的对象并理解它们之间的关系,这对于监视这类应用很有用。

3.3 基础模型中有效的分割(低成本)

论文地址:https://arxiv.org/abs/2312.15895

代码地址:https://github.com/zhaoyangwei123/SAPNet

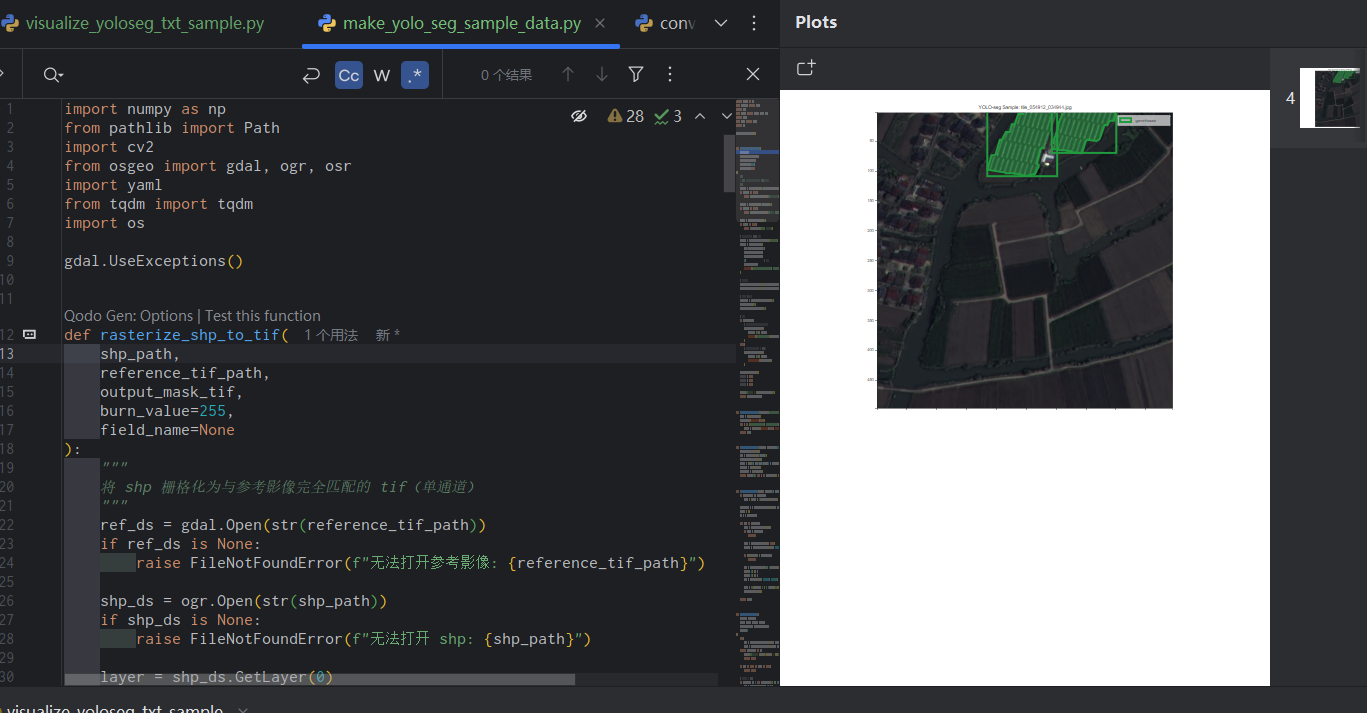

创新点:语义感知实例分割网络 (SAPNet) 的开发,它使用点提示将多实例学习 (MIL) 与 SAM 等视觉基础模型集成在一起。 SAPNet 通过战略性地选择代表性掩模提案并通过点距离指导和框挖掘策略解决分割挑战来增强特定于类别的分割。

潜在应用:

a) 自动驾驶:改进自动驾驶车辆系统中的物体检测和分类,从而提高决策和安全性。

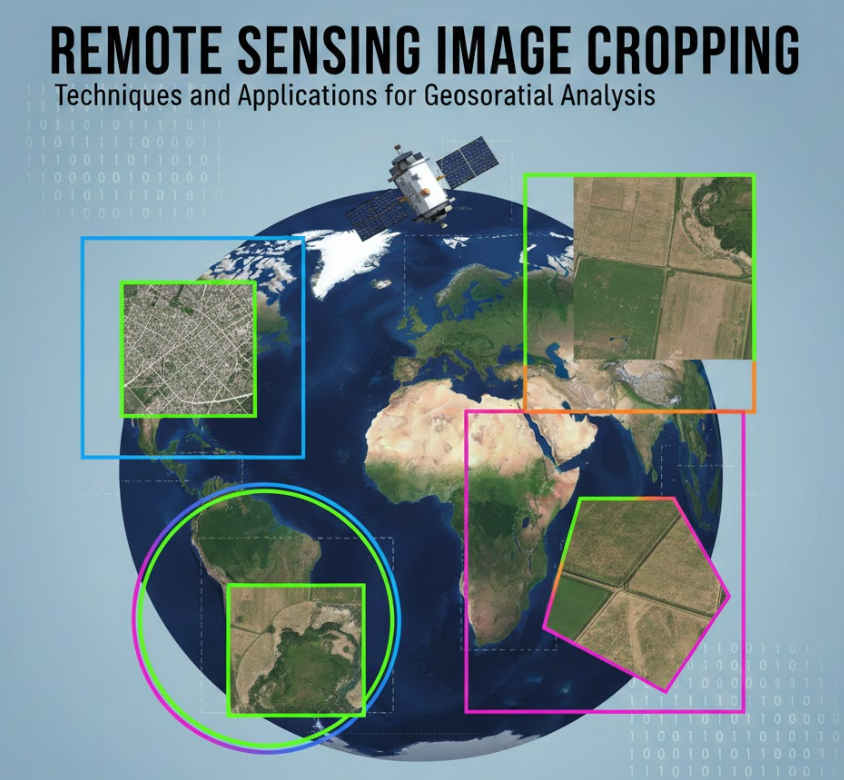

b) 农业监测:通过航空或卫星图像对特定作物或植物进行精确分割,以实现更好的农业管理和产量预测。

3.4 在基础模型中使用视觉提示以实现更好的图像分割

论文地址:https://arxiv.org/pdf/2404.11732

代码地址:https://github.com/rayat137/VisualPromptGFSS

潜在应用:

a) 自动驾驶车辆:通过最少的示例快速适应识别和分割新物体或路况,同时保留常见道路元素。

b) 卫星图像分析:通过少量示例识别和分割新类型的土地利用或环境变化,同时保持地理特征。

3.5 主动学习与视觉语言模型(VLM)提示的结合

论文地址:https://arxiv.org/pdf/2311.11178

代码地址:https://github.com/kaist-dmlab/pcb

创新点:开发了一种名为 PCB 的新型主动学习框架,专门为预训练的视觉语言模型 (VLM) 设计。这种方法解决了使 VLM 适应新任务的挑战,同时最大限度地减少对标签的需求。

潜在应用:

a) 医学成像:快速调整 VLM,以最少的专家标记来识别新的疾病模式或异常。

b) 电子商务:通过使用有限的手动输入使 VLM 适应新产品线,提高产品分类和搜索能力。

4. 下一步是什么

正如我们在本文中讨论的,视觉提示使得在输入空间中调整基础模型成为可能。这一点至关重要,因为这一输入充当了人类与模型之间的通用接口。在视觉领域,可提示模型很可能重塑传统计算机视觉流程的运作方式。许多这类模型可以被视为构建模块,它们将取代传统流程中的一些常见阶段(例如,标注)。

换句话说,通过视觉提示技术,我们现在能够在输入层面灵活地调整基础模型,这对于连接人机交互至关重要。在视觉模型领域,具备提示能力的模型正引领着计算机视觉传统处理流程的变革。这些模型就像是新的基石,它们有望替代传统流水线中诸如图像标注等常规步骤,从而简化和优化整个视觉处理流程。