如何在配备RTX 2060 Super的电脑上安装深度学习大模型:经验分享

如何在配备RTX 2060 Super的电脑上安装深度学习大模型:经验分享

ytkz许多深度学习的大模型都是开源的,这意味着如果你拥有一台配置不错的电脑,你完全可以在本地安装并运行这些大模型。鉴于此,我决定记录下自己在一台配备了GeForce RTX 2060 Super GPU的电脑上安装大模型的全过程,希望能帮助到有类似需求的朋友们,让你们在这一过程中少走一些弯路。以下是具体的步骤:

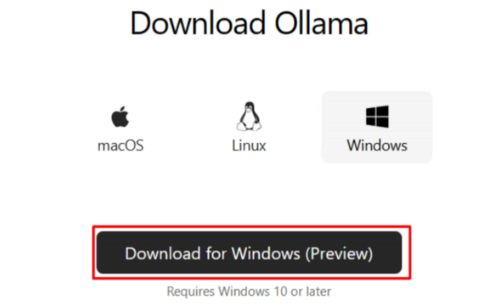

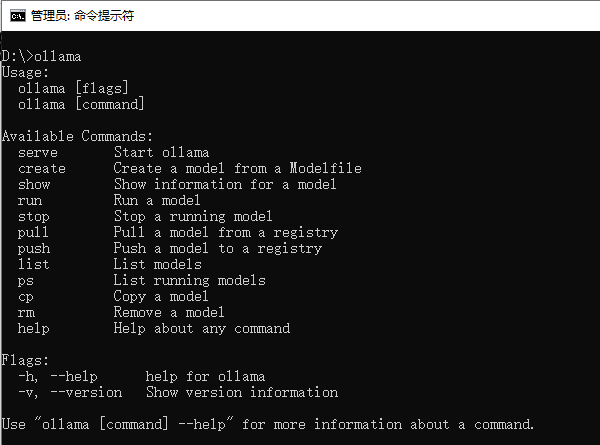

1、下载ollama,并安装它。

下载完成后,双击下载的安装程序,点击Install进行安装。安装完成没有提示,我们打开一个终端,本文以CMD为例,现在Ollama已经安装完了。在cmd窗口输入ollama,即可了解常用的Ollama命令。

2、在命令行输入:

ollama run qwen2.5等待安装千问大模型,本次我安装的千问2.5版本。

3、使用大模型

大模型的能力很强,比如文心一言、通义千问、chatgpt等等。

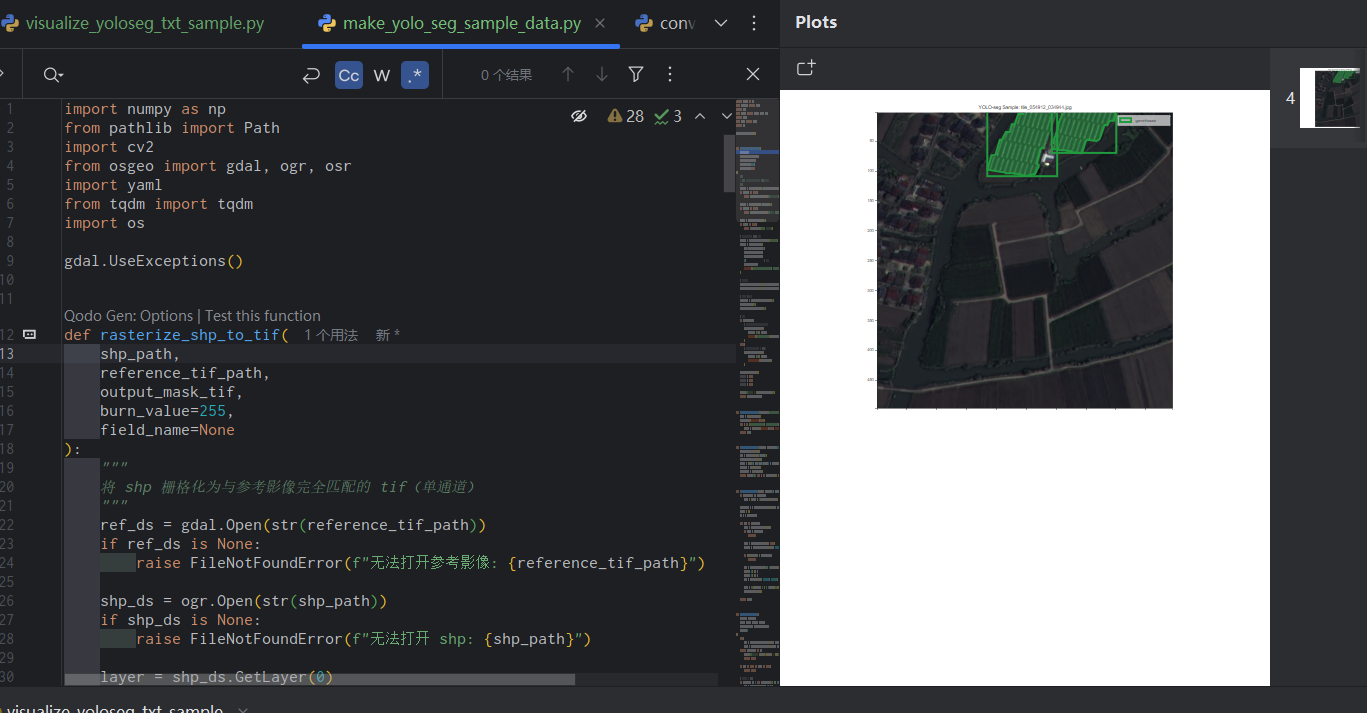

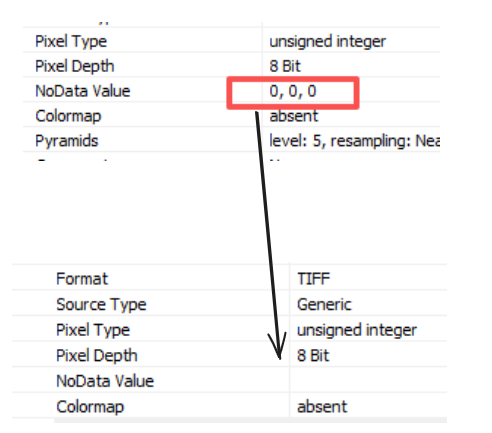

而这次选择本地安装大模型的目的,是为了在本地搭建一个翻译器,把中文翻译为英文。

好像我的电脑配置不行啊,卡顿卡顿的。明年要去换个好显卡了!

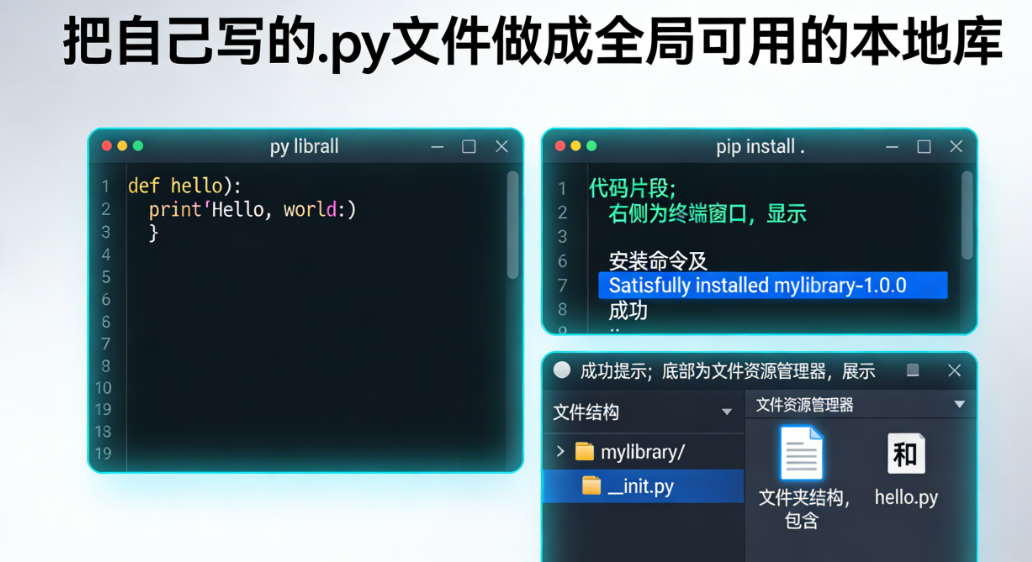

题外话

我们平常在自学编程的时候,可以去借助大模型去学习,这样的效率最高。