DINOv3是什么?DINOv3解决了遥感中哪些难点?

DINOv3是什么?DINOv3解决了遥感中哪些难点?

ytkzDINOv3是什么?DINOv3解决了遥感中哪些难点?

在计算机视觉领域,预训练模型的发展正快速演进。Meta 最新发布的 DINOv3,成为了自监督视觉模型中的新里程碑。它最大的亮点是:冻结主干(frozen backbone)即可在密集预测任务中达到最先进的效果,让团队能够“少折腾大模型,多专注小任务头(head)”。

为什么 DINOv3 值得关注?

- 大规模无标签预训练

DINOv3 使用自监督学习(SSL),在两个超大规模数据集上训练:- LVD-1689M(16.89 亿张网络图像)

- SAT-493M(4.93 亿张卫星图像)

不依赖人工标注,就能充分利用数十亿张图像。

- 开箱即用的密集特征

主干冻结后,仅用简单的线性或轻量级 head,就能在分割、深度估计、图像检索等任务中拿到 SOTA 结果。 - 跨领域的单一主干

一个 DINOv3 主干即可跨越自然图像、卫星遥感、工业检测等领域,性能超过很多专门微调的模型。 - 生态支持完善

已经登陆 Hugging Face,配备官方 API、模型卡和示例代码,可以即刻上手。

DINOv3 的技术升级(相对 DINOv2)

- 训练目标改进:

DINO 自蒸馏 + 多视角裁剪、多遮挡(iBOT)、[CLS] 正则化(KoLeo)、新提出的 Gram anchoring,解决了长时间训练中密集特征退化的问题。 - 大模型训练三阶段策略(7B 模型):

- 预训练

- Gram 锚定

- 高分辨率自适应(保证输入尺寸更大时特征依旧清晰)

- 模型家族:

- ViT 系列(S/B/L/H+/7B)

- ConvNeXt 蒸馏版(轻量级,适合边缘/实时场景)

- 卫星遥感专用版本(SAT-493M 预训练)

实际应用推荐

- 边缘或实时任务:ConvNeXt-Tiny/Small,或 ViT-B 蒸馏版

- 通用服务器任务:ViT-B/L 蒸馏版

- 离线超大图像处理:ViT-H+ / ViT-7B(冻结主干,滑窗推理)

任务表现(冻结主干 + 轻量级 head)

- ADE20K 语义分割:

ViT-B 51.8 mIoU → ViT-L 54.9 → ViT-7B 60.7 - NYU 深度估计:

ViT-L AbsRel=0.352,ViT-7B=0.309 - GEO-Bench 遥感分类/分割:

ViT-7B 略优于 ViT-L,展现了跨传感器的强泛化能力。

在遥感与地理空间中的应用价值

- 案例:世界资源研究所(WRI)利用 DINOv3 对卫星/无人机影像进行树木计数和高度估算,并验证了它的跨传感器泛化能力,避免了不同数据源下频繁重训的高昂成本。

- 农业、林业、灾害监测:在 GEO-Bench 基准上,DINOv3(卫星预训练版)已展现出强大效果。

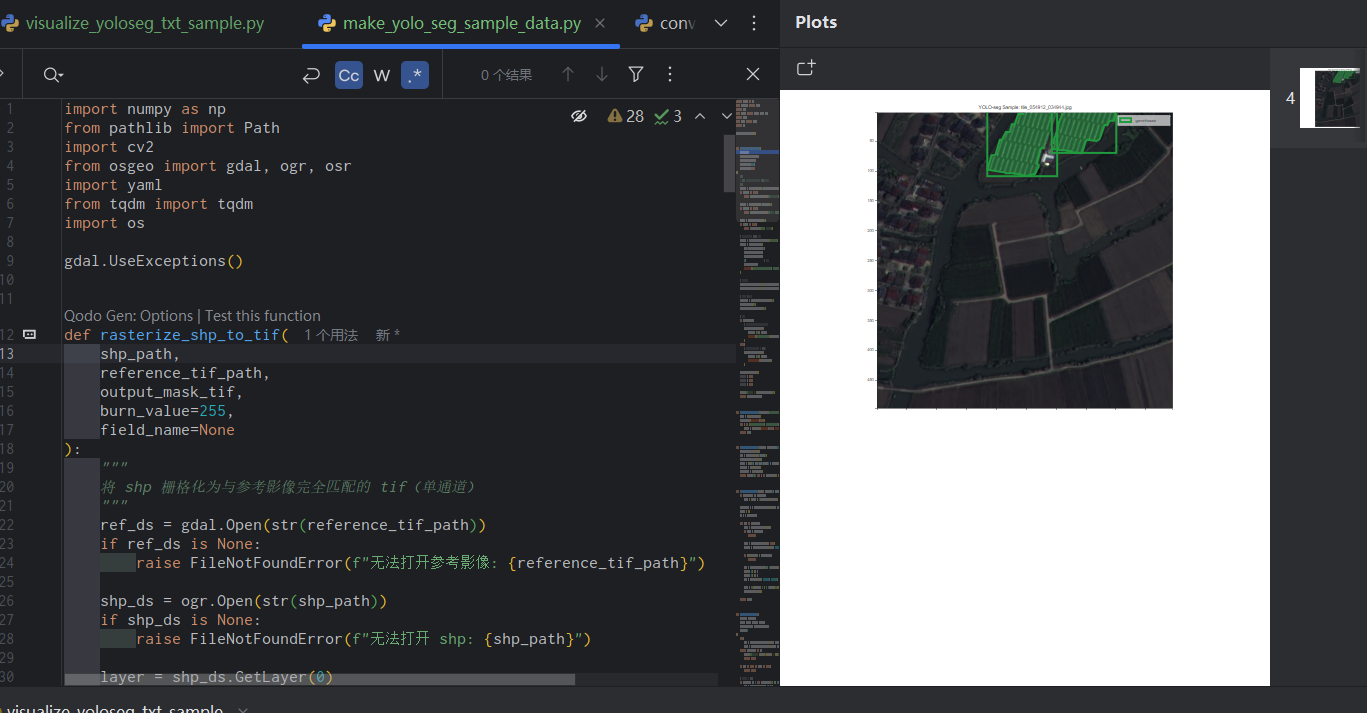

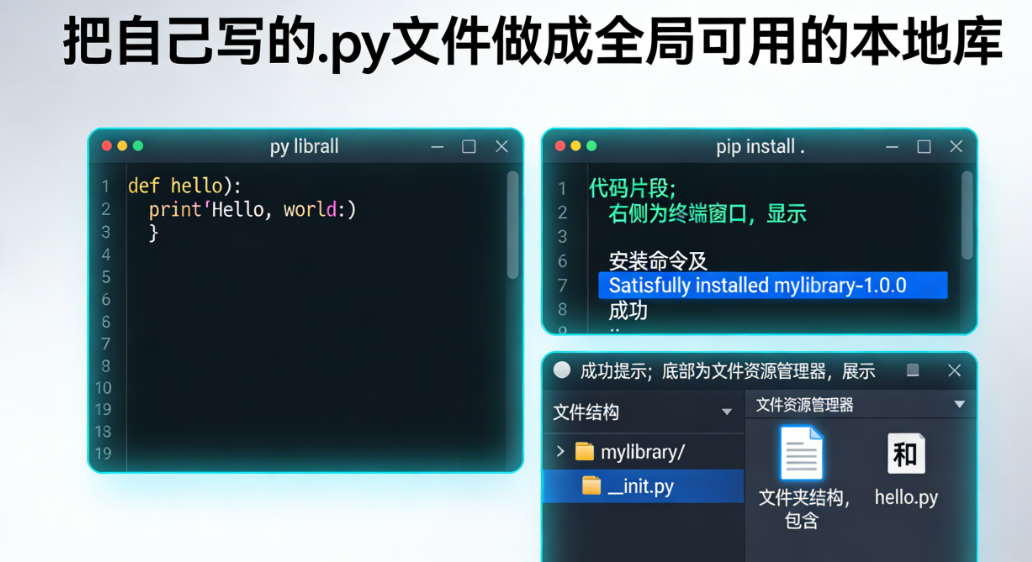

实践与代码示例

DINOv3 已在 Hugging Face 提供接口,可以轻松提取全局特征和密集特征,再接一个轻量级分割头:

from transformers import AutoModel, AutoImageProcessor

from transformers.image_utils import load_image

import torch

model_id = "facebook/dinov3-vitb16-pretrain-lvd1689m"

processor = AutoImageProcessor.from_pretrained(model_id)

model = AutoModel.from_pretrained(model_id, device_map="auto")

img = load_image("http://images.cocodataset.org/val2017/000000039769.jpg")

inputs = processor(images=img, return_tensors="pt").to(model.device)

with torch.inference_mode():

outputs = model(**inputs)

# 提取密集特征

num_regs = model.config.num_register_tokens

patch_flat = outputs.last_hidden_state[:, 1 + num_regs:, :]

B, N, C = patch_flat.shape

H = W = int(N ** 0.5)

feat_map = patch_flat.reshape(B, H, W, C).permute(0, 3, 1, 2)冻结主干 + 轻量级 head 的范式,意味着你只需少量计算,就能在分割、深度等任务中快速落地。

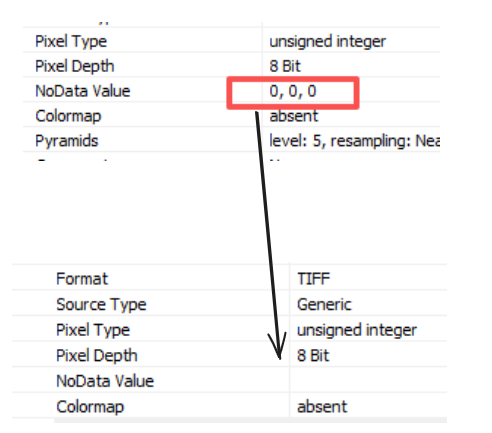

部署注意事项

- 输入图像尺寸必须是 16 的倍数,否则模型会裁剪;建议使用 padding 或滑窗推理。

- 仅使用 patch tokens 构建密集 head,去掉 [CLS] 与 register tokens。

- 可进行 int4 量化,减少 ViT-7B 推理成本。

- 许可限制:权重为门控下载,需要同意 Meta 的自定义 DINOv3 License。

总结

DINOv3 代表了视觉主干的发展趋势:

- 预训练规模极大(数十亿图像,自监督)

- 特征可迁移性强(跨领域、跨任务)

- 工程上实用(冻结主干 + 小 head 即可达到 SOTA)

对于 地理空间分析、工业检测、零售布局、交通智能、智慧城市 等团队而言,DINOv3 提供了一种“一套主干走天下”的解决方案,既降低了微调成本,又提高了模型复用性。

未来一段时间内,DINOv3 很可能成为视觉领域的“通用骨干”,为大规模部署和跨领域应用奠定基础。