rust

未读使用方法[source.crates-io]

replace-with = 'mirror'

[source.mirror]

registry = "https://mirrors.tuna.tsinghua.edu.cn/git/crates.io-index.git"

注:$CARGO_HOME:在 Windows 系统默认为:%USERPROFILE%\.cargo,在类 Unix 系统默认为:$HOME/.cargo。

注:cargo 仍会尝试读取不带 .toml 扩展名的配置文件(即 $CARGO_HOME/config),但从 1.39 版本起,cargo 引入了对 .toml 扩展名的支持,并将其设为首选格式。请根据使用的 cargo 版本选择适当的配置文件名。

在 Linux 环境可以使用下面的命令完成:

mkdir -vp ${CARGO_HOME:-$HOME/.cargo}

cat << EOF | tee -a ${CARGO_HOME:-$HOME/.cargo}/config.toml

[source.crates-io]

replace-w ...

在坐着车,突然想到了一个AI模型训练的一个好的idea。

心情本来不是特别坏,也不是特别好,但是想出这个idea之后,灵感就迸发了,很多事情都想通了。

立刻打开微信我的文件,一个人自言自语开始语音转文字。司机时不时眼睛微斜用余光看看我的精神状态是否正常。

现在我的主业是做ai的,曾经的遥感预处理都与我无关。

我是半路做AI的,不妨碍我现在能做出效果很好的应用。

我是真有这个信心,你说AI难吗?也很难,但是很多人都把ai集成为一个工具了,比如yolo,比如sovits

相对来说,模型我都是用开源的,哪个效果好我就用哪一个,我会更花更多的时间在后面的细节处理,在实战中检验效果。

对于初学AI者来说,我觉得更好的理解模型的方式是研究一个很基础模型,然后用笔和纸把模型的结构一层一层的从白纸上面写出来,理解它们这个层层递进的一个处理关系。

以前我写过拆解模型的过程。

【深度学习】从LeNet学神经网络搭建

LeNet很简单,很容易去解析,套路都是惊人的相似的。

再进阶一点,可以按照GPT训练的模式,自己构建一个小的模型。当然,此时学习的是训练的手法,怎么蒸馏等等。

我现在电脑算力不行,等我的5 ...

安卓手机都有加速度计,就是手机横置时让屏幕翻转的那种传感器,它可以侦测到手机的移动。

如果系统发现,同一个地理区域的手机突然同时震动,就说明地震了。谷歌就会向该区域的用户推送地震警报。

该系统于2021年4月,首先在新西兰和希腊上线,已覆盖98个国家/地区。2023年11月的菲律宾6.7级地震,2023年11月的尼泊尔5.7级地震,它都发送了警报。

今天微信小程序 《小白gps工具》已通过审核,终于可以上线使用。

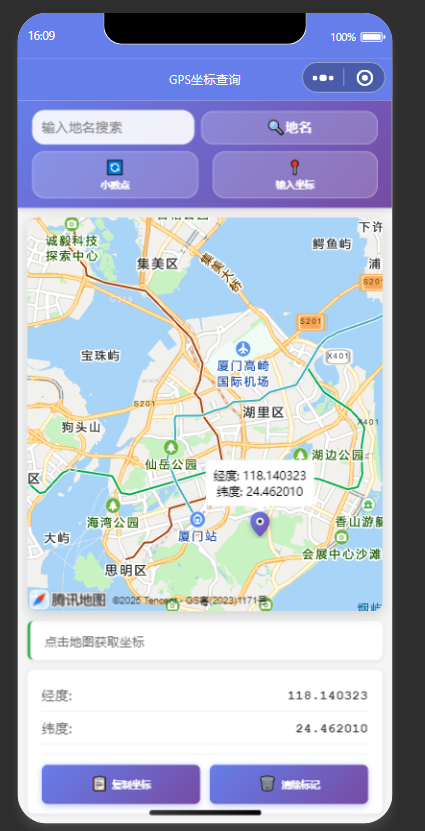

作为第一个版本,小白gps工具主要提供查询位置信息、输入坐标反查地图。

我没有条件外出进行gps静态测量,所以本次以google maps的经纬度为基准,在google maps、小白gps工具 手动刺点。进行简单的坐标精度测试。

挑选具有明显特征的位置:厦门旁边的双鱼岛,具体位置如下:

放大后显示如下:

再放大如下:

图上红色框的位置在google maps的经纬度是 118°4′0.26″E,24°23′7.37″N、

现在,在微信小程序 小白gps工具 测试该点的经纬度是118°4’0.17”E, 24°23’7.50”N如下:

纬度误差是13″,经度误差是9″,这种误差在日常简单的使用是没有问题的。

出现误差是因为二者的刺点是我手动操作的。

以上结果能验证 小白gps工具的位定是准确的。

当然,你想要更精确的gps定位信息,那么你需要去干测量外业。这点不在我们的讨论范围之内。

小白gps工具还提供 坐标反查,输入坐标gps信息,自动在地图上标记对应的地点。

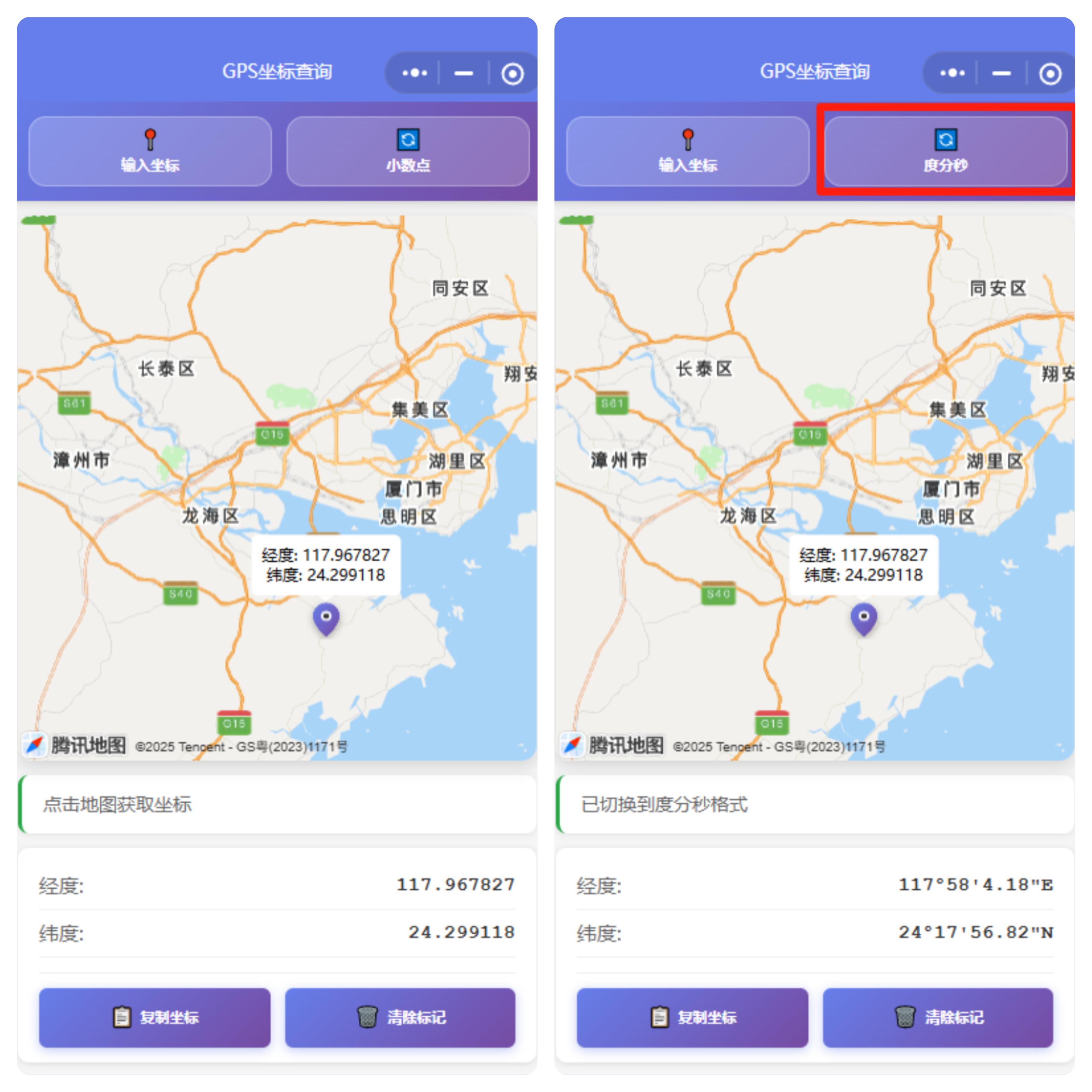

坐标的格式有两种,小数点格式和 ...

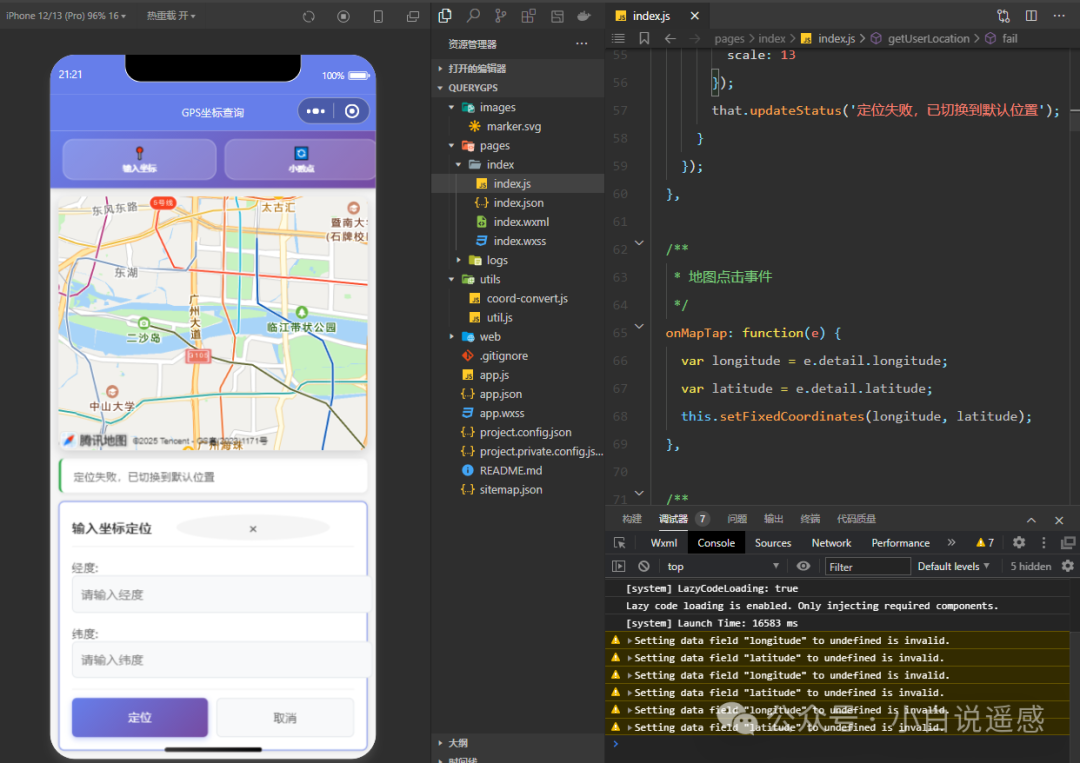

背景我开发了一款微信小程序,专注GPS坐标查询。功能包括地图点击获取经纬度、地名搜索定位、坐标格式转换(小数度/度分秒)、坐标分享及用户定位。

初期使用OpenStreetMap的Nominatim API进行地名搜索,但因国内访问不稳定,切换到高德地图地理编码API,提升了搜索效率。

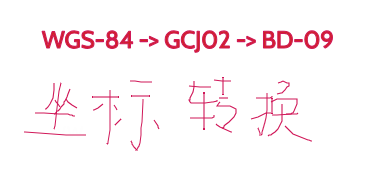

实现要点1.地图交互使用微信小程序的 组件,支持点击获取GCJ02坐标,转换为WGS84显示,并添加标记点。

2.地名搜索通过高德地图API实现地名搜索,返回坐标,直接适配地图组件,响应快,覆盖广。

3.坐标格式转换支持小数度和度分秒格式,coord-convert.js 模块处理WGS84与GCJ02转换及格式切换。

/**

* 坐标转换工具类

* 移植自Python版本的coord_convert.py

*/

class CoordConverter {

constructor() {

this.x_pi = Math.PI * 3000.0 / 180.0;

this.a = 6378245.0; // 长半轴

this.ee = ...

你是否曾经有过这样的经历:用着好好的谷歌地图,一到国内,发现自己的GPS定位和地图上的道路总有那么一点点偏移?或者在使用卫星图时,发现道路、建筑的标注和实际影像对不上号?

别担心,你的手机没坏,地图App也没有出bug。你所遇到的,是一个涉及技术、法规和数据的有趣问题——地图坐标系。

今天,我们就来深入浅出地聊一聊这个话题。

一、 三大“标准”:谁在定义我们脚下的坐标?要理解各大地图App,我们首先要认识三个核心的坐标系“标准”:

WGS-84坐标系 (世界标准):这是我们最应该先认识的“老大哥”。它是由美国国防部制定的世界大地测量系统 (World Geodetic System 1984)。它的应用太广泛了,你手机里的GPS芯片接收卫星信号计算出的经纬度,就是基于这个标准。可以说,WGS-84是目前全球范围内的“事实标准”,代表着地球上一个点的“真实”坐标。

GCJ-02坐标系 (中国标准,又称“火星坐标系”):出于国家地理信息安全的考虑,中国国家测绘局规定,所有在中国境内发布和使用的地图产品,都必须采用一套国家加密的坐标系统。GCJ-02就是这套官方系统,它是在WGS-84的 ...

最近我会做两个微信小程序,代码初步写完。

第一个小程序正在备案,估计过两天备案审核通过后就上线,第二个小程序还没申请。

第一个小程序是查询经纬度。

第二个小程序是台风轨迹可视化。

在这两个小程序上线的时候,我会好好写一下这些小程序是怎么实现的、以及花了多少钱。

实际上,今年下半年,我计划开发一款GPS记录软件,用于完整记录用户的移动轨迹。我已经调研过市场上的类似应用,例如iOS平台上有一款名为“迷雾世界”的App。

然而,现有的这些App存在一个显著缺点:一旦开启,它们会实时从手机读取GPS信息,这会导致严重的电量消耗。

我的思维往往跳跃性很强,有时做事显得不太靠谱。但在许多情况下,我都能精准抓住事物的核心矛盾。

当然,发现问题远比解决问题容易得多。

如果能从根本上解决核心矛盾,许多衍生问题将迎刃而解。

等到明年年初,我会入手一张RTX 5090显卡,认真投入AI相关的自媒体创作。

目前,我已积累了一些AI自媒体的技术经验,但这个公众号专注于遥感领域,因此我不会在这里展开讨论。

2025年7月初,我写了一篇文章,讨论了在当前的AI时代,我们是否还需要学习编程。

我的答案是肯定的。我们不能只依赖AI。我们要看得懂AI给我们的答案,起码,我们要知道自己期待的答案是什么。

2025年7月第二篇《输出是最好的学习》,属于劝学。我本身是一个懒人,持续学习只是为了让自己生活过得好一点点。

在我们这个行业,如果要涉及到编程,你是绕不开GDAL,我们有必要认真学习GDAL。

那么学习rasterio还是gdal呢?我给出了一些建议。

当然,你学到好也不一定能找到工作,因为遥感领域最大的难题是本科生毕业找工作的问题。

同时,高校也在与时俱进,设立新专业:时空信息工程。

因许久未更新公众号,近日从过往积累的代码库中整理并提炼出 SAR 去噪相关内容,于 2025 年 7 月 31 日正式发布。

7月共发表了9篇公众号文章,大部分的业余时间是在当一个赛博监工。

结合ai编程,我做几个有意思的东西。比如你看到的开头的视频就是全自动生成的(输入文字,输出视频)。

我以前说过不想做视频的原因是我不想用自己的声音。现在完全可以使用克隆声音的技术。

7月的总结到此结束,祝大家都生活顺利。

Shapefile修复工具 🗺️一个基于Web的Shapefile文件修复工具,专门用于检测和修复SHP文件中几何数据与属性数据不一致的问题。

这个项目展示了如何使用现代Web技术处理GIS数据格式,为GIS开发者和数据分析师提供了一个实用的在线工具。

📖 项目背景Shapefile是GIS领域最常用的矢量数据格式之一,由多个文件组成:

.shp - 存储几何数据

.dbf - 存储属性数据

.shx - 索引文件

.prj - 投影信息

在数据处理过程中,经常会出现几何数据与属性数据记录数不一致的问题,导致数据无法正常使用。

传统的解决方案需要使用专业的GIS软件或编写复杂的脚本,而这个工具提供了一个简单易用的Web界面来解决这个问题。

🌟 功能特点

🔍 智能检测:自动读取SHP和DBF文件头信息,精确计算记录数

🔧 自动修复:根据检测结果自动添加或删除记录以保持数据一致性

📁 多文件支持:支持.shp、.dbf、.shx、.prj文件的批量处理

🎨 现代化界面:响应式设计,支持拖拽上传,提供直观的用户体验

📊 实时反馈:详细的处理进度和结果展示,包 ...

rasterio是什么?GDAL (Geospatial Data Abstraction Library) 是地理空间数据处理领域的基石。它是一个用 C++ 编写的开源库

然而,GDAL 的强大也带来了它的“缺点”。它的官方 Python 绑定 (osgeo.gdal) 是从 C++ 代码自动生成的,这导致了它的 API 对于 Python 开发者来说不够友好。

Rasterio 的诞生就是为了解决 GDAL Python 绑定的这些痛点。它把自己定位为“GDAL for Python users”,它不是要取代 GDAL,而是架设在 GDAL 强大的能力之上,提供了一个更加现代、简洁和“Pythonic”的接口。

重要的一点是:Rasterio并没有重新发明轮子,它的核心功能依然依赖于GDAL。

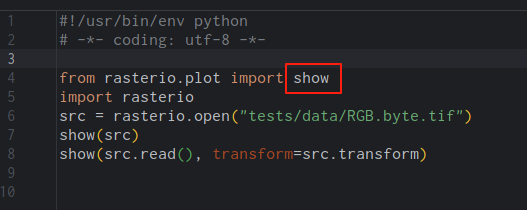

我以前是通过学习rasterio的源代码,进而学习行业内的高手是怎么封装GDAL完成不同的功能。

这个过程的步骤是:

1.安装pycharm

2.安装rasterio

3.打开在pycharm打开某个rasterio的代码。

比如下面的是rasterio封装了matplotlib、nump ...